LightShed versus NightShade & Glaze: La guerra del copyright que envenena imágenes contra la GenAI

Esta semana - después de haberos publicado el artículo de los "Hechizos de Repelencia para hacer Imágenes más creativas con inteligencia Artificial" - había aprovechado a leerme unos artículos académicos muy interesantes que demuestran la guerra que existe entre los creadores de imágenes y los algoritmos de difusión que permiten generar imágenes - y por supuesto canciones y vídeos - a partir de entrenamientos hechos con ellas. Para ello, se usar un Adversarial Attack típico de Machine Learning que envenena las imágenes con Perturbaciones, y lo que se trata es de detectar y eliminar el Posion antes de entrenar el modelo de difusión para que esté listo para utilizar.

copyright que envenena imágenes contra la GenAI

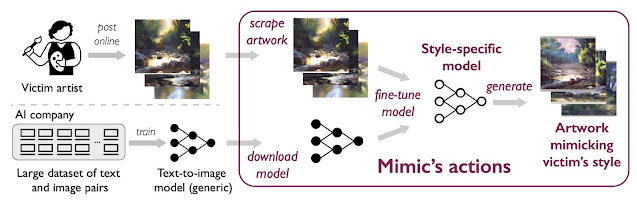

Los algoritmos de difusión tipo Stable Diffusion necesitan datos para ser entrenados, o para sufrir un proceso de Fine Tuning que los ajuste a nuevos aprendizajes. Y para eso necesitan datos. Datos que los creadores están protegiendo de diferentes formas.

Con un proceso de Fine-Tuning como el que se propone a continuación, nosotros hicimos el modelo que clonaba el estilo del magnífico artista Okuda San Miguel, en el artículo que os dejamos sobre cómo funcionan los modelos de Stable Diffusion (Dall-e & MidJourney).

Una de las propuestas es envenenar las imágenes con datos que produzcan un ataque de adversario en el algoritmo, metiendo datos que no son visibles a simple vista, pero que el algoritmo sí va a procesar. El primero de ellos es Glaze, que fue presentado en el año 2023 en el artículo "Glaze: Protecting Artists from Style Mimicry by Text-to-Image Models" y que podéis leer aquí.

La idea es inyectar datos que aparentemente no se ven a simple vista, pero que lleva al algoritmo hacia modelos totalmente divergentes con el conjunto de imágenes que se utilizó al principio. Es decir, se trata de darle una foto que aparentemente es de un perro, pero que lleva datos para que lo que "vea" el algoritmo sea una cosa diferente, ¿qué te parece un gato?

Con esto se consigue que las imágenes que acaban siendo generadas por un modelo de difusión, si han sido envenenadas con Glaze, no se parezcan en nada a las fotografías originales utilizadas para entrenar el modelo.

Una evolución de estos algoritmos de envenenamiento de las imágenes de entrenamiento se presentó el año pasado, llamado NighShade, y lo tenéis en el paper publicado con el título de: "Nightshade: Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models" que podéis leer aquí mismo.

Como se puede ver, las imágenes envenenadas con NighShade no tienen cambios perceptibles al ojo humano, y el servicio conginitivo de descripción de imágenes así lo ve, como podéis ver aquí, donde tenemos cuatro imágenes originales y su versión envenenada, así como su descripción.

En este ataque, el proceso es mucho más selectivo y se consigue envenenar una imagen con casi cualquier cosa, como se puede ver en este conjunto de imágenes que al final se pide un perro y acaba apareciendo un gato. No está mal.

Con estos ataques de adversario los creadores tienen cierta protección para sus imágenes, ya que no les van a ser útiles a los modelos de difusión como fuente de entrenamiento, pero como os podéis imaginar, los investigadores iban a trabajar en lo contrario, y así nace LightShed.

En este caso, los investigadores han publicado un algoritmo, llamado LightShed, que detecta las perturbaciones que generan los algoritmos de envenenamiento, y hacen un proceso de ingeniería inversa para revertir todos los datos inyectados por Glaze o por NighShade, generando una nueva imagen limpia.

Figura 11: Detección y limpieza con LighShed

Esto hace que cualquier proceso de entrenamiento o Fine-Tunning con un dataset de imágenes primero analice si la imagen tiene veneno (Poison), y si e es así se limpie con LighShed, para luego ya poder pasar a entrenar el modelo de difusión.

Así que, de nuevo hay que seguir con nuevas formas de jugar a este juego del "perro y el gato" que tantas veces hemos visto en el mundo de la ciberseguridad, donde alguien publica un bug y otro un parche, y luego alguien busca un nuevo bug para ese sistema parcheado, y.... y así evoluciona la ciencia. ¿no? Lecturas interesantes sobre el mundo de IA en el que vivimos.

¡Saludos Malignos!

Autor: Chema Alonso (Contactar con Chema Alonso)

DragonJAR

DragonJAR 8.8 Chile

8.8 Chile Ekoparty

Ekoparty e-Hack MX

e-Hack MX  AREA 51

AREA 51  Comunidad Dojo Panamá

Comunidad Dojo Panamá  ARPAHE SOLUTIONS

ARPAHE SOLUTIONS

No hay comentarios:

Publicar un comentario