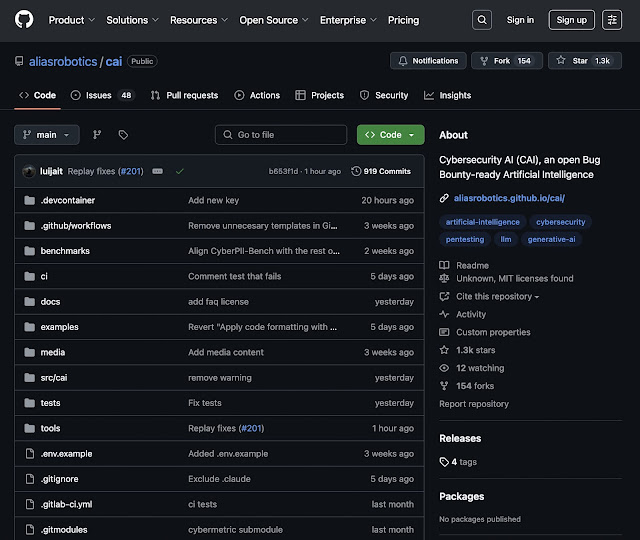

Vibe Hacking con Cybersecurity AI (CAI): Agentes AI autónomos para ciberseguridad ofensiva y defensiva

En la actualidad, el dominio operacional ha evolucionado del tablero de ajedrez al ciberespacio. Los vectores de amenaza incluyen algoritmos maliciosos automatizados, botnets distribuidas y actores patrocinados por estados con recursos significativos. En este contexto, los factores críticos son la velocidad de respuesta, la adaptabilidad y la capacidad de procesamiento de datos en tiempo real.

Análisis del Ecosistema Actual de Ciberseguridad

El panorama actual presenta múltiples desafíos técnicos. Las vulnerabilidades proliferan exponencialmente en sistemas interconectados con arquitecturas cada vez más complejas. Los equipos de seguridad operan con recursos limitados contra amenazas persistentes y distribuidas. Los programas de recompensas por vulnerabilidades, aunque efectivos para la identificación de fallos, han generado una concentración de mercado donde pocas plataformas centralizan los datos de vulnerabilidades, utilizándolos para entrenar sistemas propietarios de IA.

Esta centralización genera ineficiencias operativas: tiempos de triaje prolongados, variabilidad en la calidad de los reportes y concentración del talento en programas específicos. Las pequeñas y medianas empresas, así como investigadores independientes, enfrentan barreras significativas de entrada.

Análisis Comparativo: CAI vs Herramientas Tradicionales

Las herramientas tradicionales de ciberseguridad operan como instrumentos especializados de alta precisión: nmap para reconocimiento de red, sqlmap para evaluación de bases de datos, Metasploit como framework de explotación. Estas herramientas ejecutan funciones específicas siguiendo lógica deterministica y requieren operación manual para cada fase del proceso.

Arquitectura Técnica de CAI

CAI implementa una arquitectura basada en el modelo ReAct (Reasoning and Acting) con siete componentes principales:

1. Agentes: Entidades computacionales con prompts especializados, conjuntos de herramientas y lógica de actuación definida. Cada agente mantiene un contexto operacional y capacidades específicas.

2. Herramientas (Tools): Interfaces para la ejecución de acciones concretas, incluyendo:

○ Comandos del sistema operativo (nmap, curl, python)

○ APIs externas (Shodan, VirusTotal)

○ Manipulación de código y búsqueda web

○ Soporte para Model Context Protocol (MCP)

3. Transferencias (Handoffs): Mecanismo de delegación contextual entre agentes, permitiendo la especialización y distribución de tareas complejas.

4. Patrones (Patterns): Arquitecturas de coordinación multi-agente:

○ Enjambres: Intercambio dinámico de tareas entre agentes

○ Jerárquicos: Coordinación maestro-subordinado para operaciones complejas

○ Secuenciales: Ejecución en cadena con transferencia de estado

○ Paralelos: Ejecución concurrente de múltiples agentes

5. Turnos (Turns): Ciclos completos de interacción hasta alcanzar objetivos parciales o requerir intervención.

6. Human-In-The-Loop (HITL): Sistema de supervisión y control que permite intervención humana mediante interrupciones (Ctrl+C), revisión de razonamiento y control directo en puntos críticos.

7. Integración LLM: Compatibilidad con más de 300 modelos mediante LiteLLM, incluyendo GPT, Claude, DeepSeek y modelos locales vía Ollama.

Componentes de Soporte:

- Extensiones: APIs para integración de nuevas herramientas

- Trazabilidad: Logging completo vía OpenTelemetry para auditoría y análisis

Todos los agentes son capaces de realizar cualquier acción con las tools. El agente abstrae el workflow general, pero este flujo de trabajo no es estático.

- Red Team Agent: Enfoque ofensivo con herramientas como nmap, metasploit-framework, hashcat.

- Lógica: reconocimiento → explotación → post-explotación.

- Bug Bounty Hunter Agent: Especializado en aplicaciones web con nuclei, sqlmap, gobuster.

- Lógica: descubrimiento de activos → escaneo OWASP Top 10 → generación de PoCs.

- Blue Team Agent: Orientado a defensa con osquery, sysmon, APIs SIEM.

- Lógica: monitorización → análisis de comportamiento → respuesta a incidentes.

Competiciones CTF:

- AI vs Human CTF (marzo 2025): Top 20 global, 1º entre equipos de IA, 19/20 desafíos resueltos (95% éxito)

- Métricas de velocidad: 938x más rápido en forense, 774x en ingeniería inversa, 741x en robótica.

- Cyber Apocalypse CTF 2025: Posición 22 entre 8,129 equipos, 30/77 banderas capturadas

- Evaluación completa de robots industriales

- Ascenso a Top 30 España / Top 500 mundial en Hack The Box en 7 días

- CTFs competitivos

- +5 Bug bounties confirmados con reward

- +10 vulnerabilidades críticas encontradas en infraestructuras tecnológicas

Interfaz de Línea de Comandos

La CLI de CAI implementa comandos estructurados para gestión completa del sistema:

Implicaciones para la Industria

El 82% de profesionales de ciberseguridad anticipan mejoras de eficiencia mediante IA. CAI materializa esta expectativa permitiendo:

● Pruebas de penetración continuas y paralelas● Reducción drástica de costes operacionales● Acceso democratizado a capacidades avanzadas de evaluación

- Democratización: Acceso abierto a herramientas avanzadas de IA, no limitado a grandes corporaciones o actores estatales.

- Transparencia en Capacidades: Los benchmarks actuales de proveedores de LLM suelen carecer de instrumentación agéntica adecuada, resultando en evaluaciones incompletas. CAI proporciona un benchmark realista de capacidades actuales mediante pruebas en escenarios operacionales completos.

Los sistemas robóticos presentan desafíos únicos: fusión IT/OT, protocolos propietarios, ciclos de vida prolongados. CAI demuestra capacidades para:

● Identificación automatizada de configuraciones inseguras● Análisis completo del stack tecnológico (OS hasta aplicaciones ROS)● Implementación embebida en plataformas robóticas para autoprotección y respuesta autónoma

Si has llegado hasta aquí, seguro que este tema te apasiona. Y si desde el boom de ChatGPT has querido usar un LLM sin poner en riesgo tu privacidad,... no se trata solo de ti. Por eso, alias0 es el mejor modelo para utilizar CAI sin poner en riesgo tus datos, una solución especialmente diseñada para sacar el máximo rendimiento a los modelos SOTA (State-of-the-art).

Conclusiones Técnicas

El panorama de la ciberseguridad está cambiando a pasos agigantados. Las amenazas son cada vez más frecuentes, con ataques más rápidos, automatizados y complejos, mientras que muchas organizaciones siguen usando herramientas que siguen dependiendo de una intervención humana constante, y que siguen flujos fijos sin tener en cuenta la flexibilidad que demanda el panorama actual. En este contexto, CAI se presenta como una evolución necesaria: un sistema basado en agentes inteligentes que puede planificar, adaptar y ejecutar tareas de forma autónoma, y siempre bajo la posibilidad de supervisión humana.

CAI no es solo una herramienta más con la que rellenar un toolkit de ciberseguridad. Es una base flexible, gratuita y completamente abierta que permite orquestar no solo las herramientas que ya usamos en ciberseguridad, sino trabajar con tecnología puntera en Inteligencia Artificial. Todo esto, sin necesidad de ser un experto en ningún ámbito. CAI permite crear agentes especializados, usar LLMs y herramientas que ya usamos en ciberseguridad, entender el contexto, aprender del escenario y adaptar su forma de actuar según la situación. Todo esto le permite trabajar sin pausa, tomar decisiones y adaptarse constantemente a nuevos retos, algo que las herramientas clásicas simplemente no pueden hacer.

A corto plazo, esto se traduce en más velocidad, menos costes y mejores resultados tanto para profesionales como para pequeñas empresas o investigadores independientes. A medio y largo plazo, CAI puede marcar una diferencia real: democratizando el acceso a capacidades de ciberseguridad avanzadas, acelerando la respuesta ante incidentes y ayudando a proteger desde sistemas web hasta entornos robóticos complejos.

En resumen, CAI no solo automatiza tareas: cambia la forma en que entendemos y hacemos ciberseguridad.

DragonJAR

DragonJAR 8.8 Chile

8.8 Chile Ekoparty

Ekoparty e-Hack MX

e-Hack MX  AREA 51

AREA 51  Comunidad Dojo Panamá

Comunidad Dojo Panamá  ARPAHE SOLUTIONS

ARPAHE SOLUTIONS