miércoles, julio 30, 2025

miércoles, julio 09, 2025

GenAI Search Engine Optimization (GenAI SEO) con LLMs TXT

#Datos de la web donde está el fichero LLMs.txt> Resumen de la sección completa.- Información sobre cosas que se pueden encontrar en esta sección- Detalles de lo que hay en esta sección.- Descripción de cosas importantes a saber.## Sección 1 de la web- [Título de la pagina a visitar] (URL de la pagina): Descripción de lo que hay allí.- [Título de la pagina a visitar] (URL de la pagina): Descripción de lo que hay allí.- [Título de la pagina a visitar] (URL de la pagina): Descripción de lo que hay allí.- [Título de la pagina a visitar] (URL de la pagina): Descripción de lo que hay allí.- [Título de la pagina a visitar] (URL de la pagina): Descripción de lo que hay allí.

Publicado por

Chema Alonso

a las

6:01 a. m.

0

comentarios

![]()

Etiquetas: AI, Artificial Intelligence, BlackSEO, ChatGPT, cloudflare, DeepSeek, GenAI, GenerativeAI, Google, hackers, IA, Inteligencia Artificial, LLM, LLMs, Perplexity, robots, SEO

jueves, julio 03, 2025

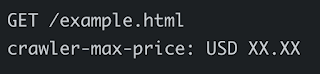

Cloudflare Pay-Per-Crawl: Un servicio que ayuda a las webs a negociar el pago por acceso al contenido que hacen los crawlers de IA

Publicado por

Chema Alonso

a las

6:01 a. m.

0

comentarios

![]()

Etiquetas: Artificial Intelligence, bots, ChatGPT, Cloud, cloudflare, DeepSeek, GenAI, Google, IA, Inteligencia Artificial, Perplexity, robots

martes, junio 03, 2025

Physical AI para Robots: Training con Digital Twins, Digital "Cousins" y Digital "Nomads" para pasar el Physical Turing Test

Publicado por

Chema Alonso

a las

5:01 a. m.

1 comentarios

![]()

Etiquetas: 3D, AI, GenAI, Generative AI, IA, Inteligencia Artificial, LLM, LLMs, robots, VR/AR

sábado, marzo 29, 2025

Air Gapping Comms para Robots "Malignos"

"Laife gets Better"

- BASIC 1.0 Copilot para AMSTRAD CPC 6128

- Sentimetrics: Detector de Deepfakes basado en las emociones de la comunicación al estilo Blade Runner

- Cloned Voice Detector & HashVoice: Sellado de audios con esteganografía

- My Giant Sarcastic "Robot" Mode & Aura Role Play Recommender

- I, Robot: El problema de Shadow AI y las Botnets de Robots con IA

- Adivina, adivinanza: ¿Está un robot con IA pasándole un mensaje oculto a otro robot con IA?

- Estego & Cripto sólo al alcance de Deep Reasoning AI

- Air Gapping Comms para Robots "Malignos"

- Cómo robar claves de cifrado de curva elíptica en OpenPGP - GnuPG con técnicas Tempest

- Extracción de claves GnuPG con el poder de tu mano (Jedi)

- DiskFiltration & USBee: Nuevas técnicas para exfiltrar datos de servidores desconectados #Tempest

- Robar datos de servidores aislados usando GSM, RF o Calor

- Cómo controlar un troyano en un equipo desconectado de la red usando SSIDs WiFi maliciosos

- Tempest: En busca de software y hardware más silencioso

- Deep-Tempest: DeepLearning para reconstruir texto de imágenes captadas con técnicas TEMPEST en señales HDMI

|

| Figura 4: DiskFiltration White Paper |

Como ultima reflexión, para terminar ya, uno de los pensamientos que teníamos es si no nos empezaremos a encontrar ya controles de seguridad basados en que no pueda venir un humano a hablar con un dispositivo con IA, y que dejemos atrás el famoso "I am not a Robot", para pasar al más moderno "I am not a Human", donde el reto debe resolverse en un tiempo que para un humano sería imposible, como este ejemplo donde hay criptografía, resolución de un problema cognitivo visual, y un tiempo para resolverlo más allá de lo que nosotros, pobres humanos, somos capaces.

Publicado por

Chema Alonso

a las

6:01 a. m.

2

comentarios

![]()

Etiquetas: AI, Artificial Intelligence, GenAI, Generative-AI, GenerativeAI, IA, Inteligencia Artificial, LLM, LLMs, robots, SLM

Entrada destacada

+300 referencias a papers, posts y talks de Hacking & Security con Inteligencia Artificial

Hace un mes comencé a recuperar en un post mi interés en los últimos años, donde he publicado muchos artículos en este blog , y he dejado mu...

Entradas populares

-

Circula por la red un truco que llegó a mí de casualidad , donde se explica cómo conseguir ver más de una vez - e incluso capturar - las fot...

-

Ayer publiqué un post que tiene ver con las opciones de privacidad de Facebook asociadas a los correos electrónicos , y mañana sacaré la se...

-

Las técnicas de OSINT son aquellas que te permiten buscar información en fuentes abiertas. O lo que es lo mismo, sacar datos de plataformas...

-

Hoy os traigo una " microhistoria " peculiar que tiene que ver con la historia de la tecnología. Es una historia de esas que empie...

-

Hace mucho tiempo, cuando se creo el " Modo Incógnito " de los navegadores, que algunos llamaron también " Modo Privado ...

-

Dentro de una investigación de una fotografía, tal vez te interese saber dónde está hecha, o a qué hora se hizo. Cualquiera de esas dos info...

-

Conseguir la contraseña de Facebook de una cuenta es una de las peticiones más usuales que se suele recibir de la gente que busca solucion...

-

Una de las opciones que se puede configurar a nivel de hipervínculo, de documento o de servidor web en los navegadores es el funcionamiento...

-

El SEPE (Servicio Público de Empleo Estatal) ha sido víctima de la archiconocida crisis del COVID-19 enlazando la avalancha de expedientes...

-

La app de mensajería instantánea Telegram tiene muchos fans por el atributo de seguridad que ha querido potenciar desde el principio, per...

DragonJAR

DragonJAR 8.8 Chile

8.8 Chile Ekoparty

Ekoparty e-Hack MX

e-Hack MX  AREA 51

AREA 51  Comunidad Dojo Panamá

Comunidad Dojo Panamá  ARPAHE SOLUTIONS

ARPAHE SOLUTIONS