sábado, enero 04, 2025

jueves, mayo 10, 2018

Neto: Un framework en Python para analizar extensiones de Chrome, Firefox y Opera

|

| Figura 2: NETO en GitHub |

Figura 4: Neto, instalación y uso

En el vídeo que acompaña este artículo tienes el proceso de instalación, y utilización, para que desde hoy mismo te pongas a trastear con la herramienta.

Publicado por

Chema Alonso

a las

12:01 a. m.

0

comentarios

![]()

Etiquetas: Análisis Forense, Chrome, ElevenPaths, Firefox, Google Chrome, kali, Kali Linux, Malware, Mozilla Firefox, Opera, Python, Software Libre

domingo, abril 26, 2015

Web Browser Cache Snooping para espiar tu ubicación GPS

|

| Figura 1: Web Browser Cache Snooping para espiar tu ubicación GPS |

|

| Figura 2: WhitePaper de los investigadores sobre Geo-inferencia por exploración de caché |

|

| Figura 3: Con Google, Craiglist y Google Maps se puede ubicar tu zona GPS |

|

| Figura 4: Geo-inferencia por carga de imagenes |

|

| Figura 5: Carga de resultados de XMLHttpRequest generando error de CORS |

|

| Figura 6: Diferencias en tiempo de generación de error entre documento en caché o no cacheado |

|

| Figura 7: Cálculo de tiempo de carga de propiedades de una imagen |

|

| Figura 8: Cálculo de tiempo de iframe cacheado o no de Craiglist |

|

| Figura 9: Cálculo de imágenes de recursos de Google Maps a cargar según ubicación GPS |

Figura 10: Vídeo demostrativo de Geo-inference por caché (visto en hackplayers)

|

| Figura 11: Técnicas y navegadores afectados |

Las técnicas, como bien indican los investigadores son útiles en los principales navegadores de Internet, incluyendo TorBrowser.

Publicado por

Chema Alonso

a las

9:17 a. m.

0

comentarios

![]()

Etiquetas: Apple Safari, Google Chrome, GPS, Internet Explorer, javascript, Maps, Mozilla Firefox, Opera, Privacidad, TOR

jueves, diciembre 18, 2014

Google o el garante de la privacidad mundial. ¿Lo sabes?

|

| Figura 2: Alerta de posible No Neutralidad en los contenidos de HTTP/2 en Wikipedia |

|

| Figura 3: Esquema de conexión tradicional (sin usar un Proxy HTTP) en HTTP/1 |

En el caso de que la conexión no vaya cifrada, entonces el contenido del tráfico puede ser visto por cualquiera que acceda a la red WiFi o a cualquiera de las redes por las que pase. Es decisión del servidor web elegir qué datos debe cifrar y cuáles no para generar un equilibrio entre privacidad y optimización, teniendo en cuenta en la parte de optimización la velocidad y el ancho de banda que es especialmente crítico en las conexiones móviles de pago.

|

| Figura 4: Esquema de conexión con SPDY Proxy de Google. Todo el tráfico HTTP es suyo |

Figura 5: Conferencia sobre ataques a clientes con un Rogue Proxy

|

| Figura 6: Servidores Proxy como addons de Google Chrome. |

|

| Figura 7: Alerta de seguridad en Google Chrome cuando instalas un servidor Proxy |

Y aquí llega la guerra, porque por defecto a día de hoy no se puede elegir. Si tu activas SPDY en tu navegador cliente Google Chrome, o si Google lo activa - como puede hacer en breve - sin decirle nada a los usurarios aprovechando su posicionamiento con Android en los terminales móviles y lo convierte en un Opt-out, entonces todo el tráfico HTTP se irá de tu navegador HTTP al SPDY Proxy de Google.

|

| Figura 8: Diapositiva de PRISM en la NSA filtrada por Edward Snowden |

En mi opinión, lo ideal sería un esquema como el siguiente, donde el usuario pudiera decidir quién debe ser el garante de la privacidad de sus conexiones. Mozilla Firefox y Opera ya han anunciado que no van a poner como Opt-out, sino como Opt-in cualquier implementación de HTTP/2 en conexiones HTTP sin cifrar por medio de un Servidor Proxy, pero Google no tiene esa opinión, y si lo hace aprovechando la cuota de mercado de Android y de Google Chrome en OSX, Windows, Linux e incluso iOS, podría hacerse con casi todo el tráfico mundial HTTP.

Publicado por

Chema Alonso

a las

9:31 a. m.

11

comentarios

![]()

Etiquetas: Android, Chrome, Google, HTTP, https, Mozilla Firefox, Opera, Privacidad, Proxy

miércoles, julio 10, 2013

Técnicas para el Fingerprinting de Web Browsers

|

| Figura 4: Comparativa de técnicas de Web Browser Fingerprinting utilizadas en diferentes sitios |

|

| Figura 5: Determinar el tamaño de fuentes en navegadores |

|

| Figura 6: Abuso de Flash para descubrir la dirección IP real detrás de un Proxy Anónimo |

Más técnicas de WebBrowsing Fingerprinting publicadas

En la DEFCON 21 se presentó el trabajo "Defense by Numb3r5", que utilizaba una técnica distinta basada en detección de navegadores usando el diferente comportamiento de los navegadores ante distintos códigos de estado HTTP.

Además, poco después se popularizó el tuco que mostraba cómo con el uso de las etiquetas eTag se pueden generar cookies sin utilizar cookies, algo que permite seguir a los usuarios que no tengan activado el uso de las cookies.

Por último, hay que destacar que se ha conocido un leak en los protocolos WebRTC que permite acceder a la dirección IP local de la conexión cuando el cliente se conecta con Mozilla Firefox o Google Chrome.

Publicado por

Chema Alonso

a las

7:39 a. m.

1 comentarios

![]()

Etiquetas: Adobe Flash, Apple Safari, Fingerprinting, fraude, Google Chrome, Internet Explorer, Java, Mozilla Firefox, Opera, Privacidad

domingo, mayo 06, 2012

Amenazas en Internet en 2011: 403 Millones de malware

Symantec ha publicado el Internet Security Threat Report 17, con el resumen de lo que ellos han visto relativo a la seguridad informática durante el año 2011. Este informe es muy similar a los Security Intelligence Report que realiza Microsoft, y siempre arrojan datos curiosos. El documento, que puede ser descargado desde este enlacen en su versión resumida [ISTR 17], trae algunos datos que llaman la atención, y otros que son ya bastante conocidos y asumidos.

Symantec ha publicado el Internet Security Threat Report 17, con el resumen de lo que ellos han visto relativo a la seguridad informática durante el año 2011. Este informe es muy similar a los Security Intelligence Report que realiza Microsoft, y siempre arrojan datos curiosos. El documento, que puede ser descargado desde este enlacen en su versión resumida [ISTR 17], trae algunos datos que llaman la atención, y otros que son ya bastante conocidos y asumidos. |

| Figura 4: Vulnerabilidades en 2010 y 2011 |

Detrás de Apple Safari quedaron Mozilla Firefox y Google Chrome, dejando a Internet Explorer en la cuarta posición en número de bugs.

Publicado por

Chema Alonso

a las

9:55 a. m.

2

comentarios

![]()

Etiquetas: Apple, Google Chrome, Internet Explorer, Malware, Opera, Safari

domingo, marzo 20, 2011

Camuflar un troyano como un vídeo en Apple Safari 5.0.4

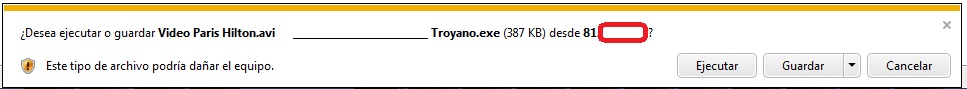

Como tuve algo de tiempo en Buenos Aires, quise probar como andaban las nuevas versiones de los navegadores contra un truco sencillo de ingeniería social. En esta ocasión es Apple Safari 5.0.4, es decir, la última versión publicada, la que cae en un engaño muy tonto a la hora de mostrar el nombre del fichero que le está descargando al usuario.

Supongamos que una web maliciosa decide mostrar un link a un supuesto vídeo de Paris Hilton haciendo sus cosas con sus amigos en uno de sus hoteles. Si el usuario de la web, ávido de conocimiento y ganas de descargar el archivo, hace clic en el fichero para que se descargue, el navegador mostrará el nombre del fichero a descargar y la opción a aplicar una vez descargado, es decir, abrir, ejecutar, guardar, etcétera.

Uno de los trucos más utilizados a lo largo de la historia ha sido el de la doble extensión. El usuario cree que está descargando un archivo .avi, pero realmente es un .avi.exe, es decir. Un fichero ejecutable.

Las últimas versiones de los navegadores de Internet Explorer, Google Chrome, Firefox u Opera, tienen especial cuidado contra este tipo de trucos, así, tienen mucho cuidado de mostrar la extensión del fichero a la hora de enseñarle al usuario el cuadro de diálogo.

Internet Explorer y Google Chrome, separan la extensión y siempre la ponen al final del archivo. En el supuesto caso de que el fichero tenga un nombre muy largo, los navegadores mostrarán la primera parte del nombre del archivo y la extensión. Firefox muestra de la extensión hacia atrás lo que entre y Opera selecciona parte del principio del nombre, y parte del final con la extensión.

Figura 1: Visualización en Opera

Figura 2: Visualización en Internet Explorer 9

Figura 3: Visualización en Google Chrome

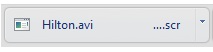

Sin embargo, Apple Safari 5.0.4 no hace eso, basta con solicitar la descarga de un fichero con un tamaño fijo de caracterectes, tal y como se ve a continuación, para que la auténtica extensión del fichero quede sustituida por unos sutiles puntos suspensivos.

Figura 4: Troyano con doble extensión simulando ser .avi

Figura 5: Visualización del troyano en Apple Safari 5.0.4

Si el usuario no presta atención a los puntos suspensivos y da al botón de ejecutar, pensando que se le va a reproducir el tan ansiado vídeo, lo que va a obtener, por el contrario, es la ejecución de un troyano. Sencillo, pero funcional y peligroso.

Saludos Malignos!

Publicado por

Chema Alonso

a las

8:00 a. m.

2

comentarios

![]()

Etiquetas: Apple, Chrome, IE9, Internet Explorer, Malware, Opera, Safari, Troyanos

domingo, mayo 23, 2010

Don´t touch my porn

El estudio intenta conocer la historia de los navegantes por medio de un algoritmo de fuerza bruta. La idea que subyace se publicó hace mucho tiempo y tiene su origen en que los navegadores muestran en diferente color los links ya visitados. Los creadores de la web, ya sea por medio de Javascript o por CSS pueden, con estas sencillas piezas de código, saber si un link se ha visitado o no.

Si Javascript está activado, se crea primero el estilo para links visitado.

Figura 1: Configuración del estilo

Y después se crea el array de sitios que se quiere saber si han sido visitados o no. Cada uno de esos sitios se convierte en un hipervínculo para, posteriormente, comprobar el color que tiene asociado ese enlace. Si coincide con el color del estilo de link visitado entonces se sabrá que desde ese navegador ha sido visitado ese link.

Figura 2: Scaneo Javascript

Por el contrario, si Javascript está desactivado, basta con crear una imagen de fondo para cada hipervínculo si este se ha visitado en la definición de la plantilla CSS. Cuando se haya visitado el link el navegador solicitará la imagen. Recogiendo las solicitudes es posible conocer las URLs visitadas.

Figura 3: Configuración estilo imagen de fondo en links visitados

Al final el sistema necesita hacerlo por fuerza bruta, es decir, deben darse los links necesarios para comprobarlos desde la aplicación que mira el historial. Esto quiere decir que si alguien ha visitado una URL que no está siendo comprobado, no se podrá saber con este método.

Para hacer el estudio tomaron el top 5.000 de Alexa de los sitios con más tráfico, para ver si podían descubrir los datos de navegación de los usuarios. La pregunta es, ¿Cuántos sitios se pueden comprobar por minuto?

Figura 4: Sitios escaneables por segundo con los dos métodos

El estudio de rendimiento se hizo con Internet Explorer 8.0, Mozilla Firefox 3.6, Safari 4, Chrome 4, y Opera 10.5 en Windows 7 usando un Intel Core 2 Quad Q8200 CPU con 6GB de RAM.

Como se puede ver, en poco tiempo se pueden comprobar muchos links del historial de un navegante aunque, si bien es cierto, es necesario contar con la transmisión de los datos por red.

¿Qué se puede hacer con esto?

Supongo que se os podrán ocurrir mil cosas que hacer con esto, o mil situaciones en las que alguien podría estar interesado en el historial vuestro. Desde sistemas de identificación de potenciales psicópatas que visitan determinadas “webs marcadas”, hasta análisis de mercados o control empresarial del uso de los recursos o saber quién está buscando curro.

En el estudio se hizo una prueba con una base de datos de sitios porno y, de los más de 243.000 visitantes que se probaron, los resultados fueron que el 21 % de los navegantes griegos, el 18 % de los españoles y el 18% de los mexicanos (que son el top 3) tenían sitios “de contenido adulto” en su historial.

Figura 5: Filtros por paises

Si a esto le sumamos los esfuerzos de identificación única de browser como el servicio de https://panopticlick.eff.org/ para identificar y tracear de forma única tú navegador, parece que los filtros de navegación anónima y los servicios de protección de la privacidad deben ser más importantes en nuestra vida.

Si quieren saber mis tendencias políticas, con quién me junto y que porno veo, que esperen a que lo ponga en mi facebook o en mí twitter, ¿qué es esto de mirar mi historial de navegación y quién soy yo?

Saludos Malignos!

Publicado por

Chema Alonso

a las

8:42 a. m.

13

comentarios

![]()

Etiquetas: Chrome, Fingerprinting, IE8, Internet, Opera, Safari, Seguridad Informática

Entrada destacada

+300 referencias a papers, posts y talks de Hacking & Security con Inteligencia Artificial

Hace un mes comencé a recuperar en un post mi interés en los últimos años, donde he publicado muchos artículos en este blog , y he dejado mu...

Entradas populares

-

Circula por la red un truco que llegó a mí de casualidad , donde se explica cómo conseguir ver más de una vez - e incluso capturar - las fot...

-

Ayer publiqué un post que tiene ver con las opciones de privacidad de Facebook asociadas a los correos electrónicos , y mañana sacaré la se...

-

Las técnicas de OSINT son aquellas que te permiten buscar información en fuentes abiertas. O lo que es lo mismo, sacar datos de plataformas...

-

Hoy os traigo una " microhistoria " peculiar que tiene que ver con la historia de la tecnología. Es una historia de esas que empie...

-

Hace mucho tiempo, cuando se creo el " Modo Incógnito " de los navegadores, que algunos llamaron también " Modo Privado ...

-

Dentro de una investigación de una fotografía, tal vez te interese saber dónde está hecha, o a qué hora se hizo. Cualquiera de esas dos info...

-

Conseguir la contraseña de Facebook de una cuenta es una de las peticiones más usuales que se suele recibir de la gente que busca solucion...

-

Una de las opciones que se puede configurar a nivel de hipervínculo, de documento o de servidor web en los navegadores es el funcionamiento...

-

El SEPE (Servicio Público de Empleo Estatal) ha sido víctima de la archiconocida crisis del COVID-19 enlazando la avalancha de expedientes...

-

La app de mensajería instantánea Telegram tiene muchos fans por el atributo de seguridad que ha querido potenciar desde el principio, per...

DragonJAR

DragonJAR 8.8 Chile

8.8 Chile Ekoparty

Ekoparty e-Hack MX

e-Hack MX  AREA 51

AREA 51  Comunidad Dojo Panamá

Comunidad Dojo Panamá  ARPAHE SOLUTIONS

ARPAHE SOLUTIONS