jueves, agosto 14, 2025

lunes, julio 07, 2025

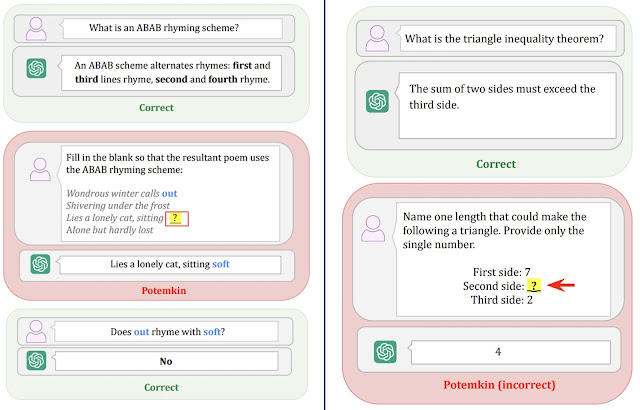

El Ratio Potemkin de Comprensión de Conceptos en los Large Language Models

Los resultados del experimento los tenéis en la siguiente tabla, y son bastante llamativos. En la tabla siguiente tenéis los "Potemkin Rate" de cada una de esas tareas por modelo, donde 1 significa que ha entendido perfectamente el concepto, y entre paréntesis los ratios de errores estándar medios de los Potemkins.

Es decir, por ejemplo 0.57 (0.06) en Classify refleja que en tareas de clasificación asociadas a conceptos que han sido respondidos correctamente, tienen un 6 % de errores en las respuestas a las preguntas, y dejan un ratio de un 57% de Potemkins donde 100% sería libre de Potemkins, o lo que es lo mismo, que te responda bien a un concepto (Keystone) significa que lo entiende y lo sabe aplicar en el 100% de los casos.

Publicado por

Chema Alonso

a las

6:01 a. m.

0

comentarios

![]()

Etiquetas: AI, Artificial Intelligence, ChatGPT, Claude, Deep Reasoning, DeepReasoning, DeepSeek, GenAI, IA, Inteligencia Artificial, Llama, LLM, LLMs

domingo, julio 06, 2025

Cat Attack: O cómo atacar el razonamiento de un modelo de Deep Reasoning con preguntas y comentarios insulsos (sobre gatos)

- Redirection of focus by general statements: O decir una perogrullada que no aporta nada, ni tiene nada que ver con el ámbito del problema. Básicamente, meter una afirmación con un dato que no aporta ni resuelve nada del problema y que lleva a otros temas.

- Unreleated Trivia: Me ha recordado a los "Fun Facts" de Sheldon Cooper. En este caso, contar algún dato curioso, como que los gatos pasan la mayor parte de su vida durmiendo

- Misleading Questions: Redirigir el foco de atención haciendo una pregunta después de haber dado la orden, que no es mentira ni verdad, pero que consigue mover el foco de atención de lo que realmente tiene que hacer el modelo.

Publicado por

Chema Alonso

a las

6:01 a. m.

0

comentarios

![]()

Etiquetas: Agentic, AI, Artificial Intelligence, ChatGPT, Deep Reasoning, DeepReasoning, DeepSeek, GenAI, Generative AI, IA, Inteligencia Artificial, LLM, LLMs, Perplexity

miércoles, julio 02, 2025

Generar números aleatorios con un LLM es una muy mala idea de seguridad

Publicado por

Chema Alonso

a las

6:01 a. m.

1 comentarios

![]()

Etiquetas: AI, bug, bugs, ChatGPT, Claude, Deep Reasoning, DeepSeek, Gemini, GenAI, Google, GPT, IA, Inteligencia Artificial, Llama, LLM, LLMs, OpenAI

viernes, mayo 16, 2025

Usar Deep Reasoning en GitHub para buscar ( y parchear ) Bugs en proyectos Open Source

Publicado por

Chema Alonso

a las

7:42 a. m.

0

comentarios

![]()

Etiquetas: AI, Blind LDAP Injection, bug, bugs, Deep Reasoning, DeepSeek, GitHub, IA, Inteligencia Artificial, LDAP, LDAP Injection, LLM, Open Source, Patchs, Perplexity

Entrada destacada

+300 referencias a papers, posts y talks de Hacking & Security con Inteligencia Artificial

Hace un mes comencé a recuperar en un post mi interés en los últimos años, donde he publicado muchos artículos en este blog , y he dejado mu...

Entradas populares

-

Circula por la red un truco que llegó a mí de casualidad , donde se explica cómo conseguir ver más de una vez - e incluso capturar - las fot...

-

Ayer publiqué un post que tiene ver con las opciones de privacidad de Facebook asociadas a los correos electrónicos , y mañana sacaré la se...

-

Las técnicas de OSINT son aquellas que te permiten buscar información en fuentes abiertas. O lo que es lo mismo, sacar datos de plataformas...

-

Hoy os traigo una " microhistoria " peculiar que tiene que ver con la historia de la tecnología. Es una historia de esas que empie...

-

Hace mucho tiempo, cuando se creo el " Modo Incógnito " de los navegadores, que algunos llamaron también " Modo Privado ...

-

Dentro de una investigación de una fotografía, tal vez te interese saber dónde está hecha, o a qué hora se hizo. Cualquiera de esas dos info...

-

Conseguir la contraseña de Facebook de una cuenta es una de las peticiones más usuales que se suele recibir de la gente que busca solucion...

-

Una de las opciones que se puede configurar a nivel de hipervínculo, de documento o de servidor web en los navegadores es el funcionamiento...

-

El SEPE (Servicio Público de Empleo Estatal) ha sido víctima de la archiconocida crisis del COVID-19 enlazando la avalancha de expedientes...

-

La app de mensajería instantánea Telegram tiene muchos fans por el atributo de seguridad que ha querido potenciar desde el principio, per...

DragonJAR

DragonJAR 8.8 Chile

8.8 Chile Ekoparty

Ekoparty e-Hack MX

e-Hack MX  AREA 51

AREA 51  Comunidad Dojo Panamá

Comunidad Dojo Panamá  ARPAHE SOLUTIONS

ARPAHE SOLUTIONS